Pułapki opinii. Coraz mniej osób chce brać udział w badaniach opinii publicznej

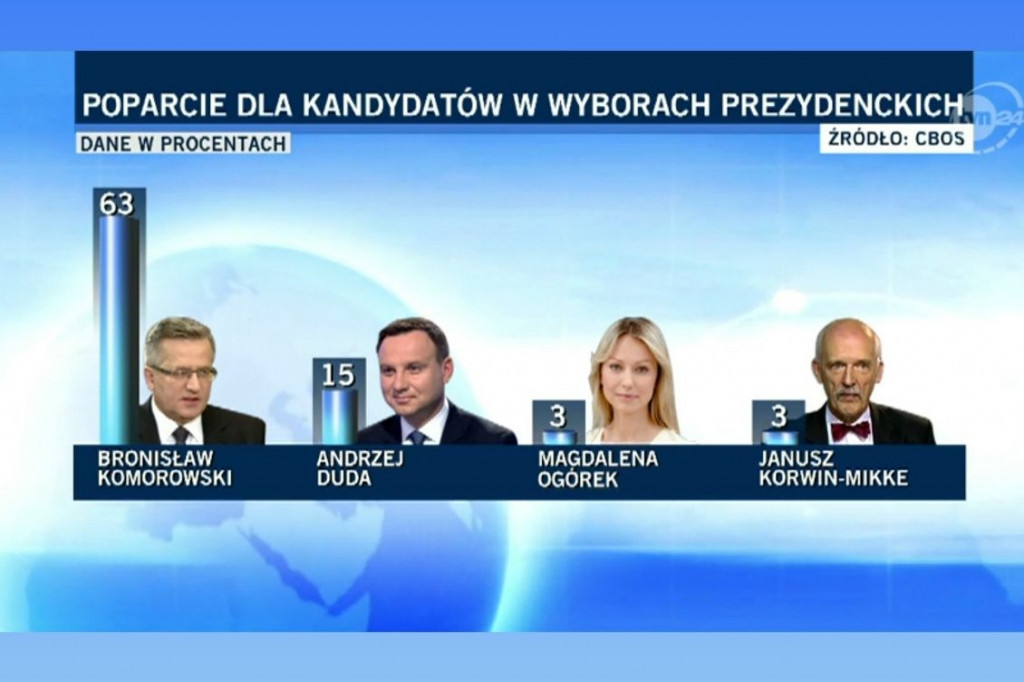

W Polsce jako dowód na błędy w odczytywaniu nastrojów społeczno-politycznych przytaczany jest najczęściej przypadek Andrzeja Dudy i Bronisława Komorowskiego (screen: tvn24.pl)

Coraz mniej osób chce brać udział w badaniach opinii publicznej. To zaważa na wynikach i skłania instytuty za granicą do testowania syntetycznych badań z użyciem AI.

Gdy w październiku 2024 roku dwie pracownie badania opinii publicznej, CBOS i United Surveys, podały wyniki sondaży, w których Koalicja Obywatelska osiągnęła ponad 33 proc. poparcia, premier Donald Tusk napisał na platformie X: „(…) Wiem, to tylko sondaże i jutro mogą być inne, ale mam dziś taką trochę chłopięcą satysfakcję, kiedy wyobrażam sobie miny ekspertów od sufitu Tuska (max 20%). Zaraz mi minie, obiecuję”.

W ten sposób Donald Tusk odniósł się do wypowiedzi ekspertów, którzy twierdzili, że maksymalne poparcie dla Koalicji Obywatelskiej wynosi około 20 proc. Takie wnioski wysunięto na podstawie sondażu Ipsos dla Oko.press i Tok FM, gdzie Prawo i Sprawiedliwość mogłoby wygrać nawet z 35-proc. poparciem, a Koalicja Obywatelska miała 26 proc. poparcia.

– Pan premier wspomina tzw. sufit Tuska z 2023 roku, a dzisiaj mamy 2024 rok – ripostuje Marcin Duma, szef i właściciel IBRiS, i dodaje, że sondaże należy traktować jako stan na dany moment.

Kilka dni później, w gruncie rzeczy wbrew opiniom mediów i sondażowni, Donald Trump sporą przewagą zwyciężył w wyborach prezydenckich w USA. Jeszcze większą niespodziankę przyniosła pierwsza tura wyborów prezydenckich w Rumunii. Călin Georgescu miał mieć według sondaży 4–10 proc. poparcia, a zwyciężył i zdobył 23 proc. Wybory odwołano.

HISTORIA POMYŁEK: DUDA KONTRA KOMOROWSKI

W Polsce jako dowód na błędy w odczytywaniu nastrojów społeczno-politycznych przytaczany jest najczęściej przypadek Andrzeja Dudy i Bronisława Komorowskiego. W styczniu 2015 roku ośrodki badania opinii publicznej oceniały, że urzędujący prezydent Bronisław Komorowski może liczyć na poparcie od 52 proc. (TNS Polska) nawet do 65 proc. (Millward Brown), a Andrzej Duda najwyżej 38 proc. (sondaż uliczny przeprowadzony przez ewybory.eu). Co prawda tuż przed wyborami przewaga Komorowskiego zmalała i w badaniu IBRiS dla Radia Zet za Komorowskim opowiedziało się 39, a za Dudą 31 proc., to jednak powszechnie uważano, że Bronisław Komorowski ma w kieszeni drugą kadencję. Nic więc dziwnego, że w programie Tomasza Lisa Adam Michnik stwierdził, iż Bronisław Komorowski przegra wybory tylko wówczas, jeśli „po pijanemu przejedzie na pasach ciężarną zakonnicę”. W rzeczywistości wygrał Andrzej Duda, a słowa Michnika do dzisiaj przytaczane są na poparcie tezy o ułomności sondaży.

Marcin Duma stanowczo nie zgadza się z tą oceną: – Zawsze na poparcie tezy, że ośrodki badające opinię publiczną się mylą, wyciągany jest screen z badania w grudniu 2014 roku, kiedy Andrzej Duda był kompletnie nieznanym politykiem, więc ówczesny wynik sondażu musiał taki być. Tymczasem wyniki badań znacząco się zmieniały do dnia wyborów w maju 2025 roku – na korzyść Dudy.

SONDAŻOWA KUCHNIA

Wśród komentujących w internecie panuje powszechna opinia, że wyniki badań nie oddają rzeczywistych nastrojów. Przykład? W Polsce dwie firmy, CBOS i IBRiS, prowadzą od dawna ranking zaufania do polityków. Badania realizowane są co miesiąc, ale w różnych terminach. Jeśli porówna się wyniki rankingu na przykład prezydenta Andrzeja Dudy, to w listopadzie 2019 roku, czyli w czasach głębokiego PiS-u, według CBOS wyrażało do niego zaufanie 56 proc., podczas gdy w IBRiS – 46,7 proc. badanych. W styczniu 2023 roku 54 proc. (CBOS) i 38,3 proc. (IBRiS). W najnowszym badaniu w listopadzie 2024 roku CBOS ocenia, że Dudę darzy zaufaniem 49 proc., a IBRiS, że 42,7 proc. Skąd tak duże rozbieżności w badaniach robionych w podobnym czasie?

– Porównywanie tych dwóch badań i wyciąganie wniosków z wielkości różnicy w procentach poszczególnych wskazań nie ma sensu, bo jako odbiorcy nic nie wiemy o jakości obu z nich – mówi Maciej Siejewicz z firmy Surveyshow. I dodaje: – Media, redakcje, dziennikarze zamawiają sondaże, otrzymują wyniki, po czym je publikują, niestety bez specjalnej troski i refleksji na temat jakości pracy wykonanej przez firmy badające, bo się po prostu na kwestiach metod realizacji badań nie znają ani nie mają świadomości wielkości wpływu jakości procesu zbierania wywiadów na uzyskiwane wyniki. Nie wiedzą, jak to zweryfikować, jakich informacji oczekiwać od wykonawców ani jaką jakość dostają za cenę, którą płacą – tłumaczy.

Według niego trudności w rozumieniu i interpretacji wynikają m.in. z nieznajomości definicji pojęć używanych w procedurze badawczej – takich jak np. próba (struktura, dobór, liczebność), losowość, reprezentatywność – i wpływu, jaki na ich występowanie w danym badaniu (bądź ich brak) ma sposób realizacji (CATI, CAWI, CAPI).

Narażone na większe wystąpienie błędów mogą być badania, które są prowadzone w ekstremalnie krótkim czasie, np. w ciągu dwóch lub trzech dni. Ankieterzy muszą wtedy za wszelką cenę zdobyć dane, a firma badawcza może nie mieć nad tym pełnej kontroli. Różnice w długości zbierania danych widać we wspomnianych badaniach rankingu zaufania polityków. Listopadowe badania CBOS prowadził od 8 do 21 listopada, a IBRiS od 22 do 23 listopada.

Błędy mogą też powstać podczas procesu tzw. ważenia. W idealnej próbie waga każdego respondenta wynosiłaby 1. Jednak w praktyce często się zdarza, że pewne grupy respondentów są nadreprezentowane lub niedoreprezentowane w stosunku do ich udziału w całej populacji. W takich przypadkach stosuje się ważenie danych. Polega to na zmniejszeniu lub zwiększeniu znaczenia poszczególnych grup respondentów, w zależności od cech, które chcemy skorygować. Jeśli w jakiejś grupie przebadano zbyt wielu respondentów, to otrzymują oni wagę poniżej 1, a jeśli za mało, to powyżej 1.

SEKRETY METODOLOGII

Zasady robienia badania opinii publicznej są znane od ponad 100 lat. Ośrodek badawczy najpierw losuje reprezentacyjną próbę badawczą, odpytuje ją na zadany temat, podlicza i analizuje wyniki.

Proste? Niezupełnie. Bo problemy zaczynają się już na etapie doboru próby.

Aby wyniki sondażu były statystycznie uzasadnione, próba badawcza musi być reprezentatywna dla całej populacji. Oznacza to, że respondenci powinni być dobierani losowo i jak najlepiej prezentować strukturę populacji pod względem cech socjodemograficznych, takich jak m.in. płeć, wiek, wykształcenie, miejsce zamieszkania itp. Idealnie byłoby wylosować z całej populacji np. 1000 osób i zapytać o ich preferencje polityczne. Jednak takie proste losowanie nie będzie skuteczne, gdyż istnieją tysiące cech, które obywateli różnią, takich jak: płeć, miejsce zamieszkania, wiek, wykształcenie czy zarobki, by wspomnieć tylko te najważniejsze. Dlatego najczęściej dobór próby badawczej odbywa się metodą kwotowo-losową, która łączy dobór kwotowy z losowym.

Celem doboru kwotowego jest zapewnienie, aby struktura próby badawczej odzwierciedlała strukturę całej populacji pod względem wybranych cech socjodemograficznych. Kwoty dla poszczególnych cech ustala się na podstawie danych statystycznych, np. z Głównego Urzędu Statystycznego. Dobór losowy w metodzie kwotowo-losowej oznacza, że po ustaleniu kwot respondenci są losowani z dostępnych baz danych lub ich numery telefonów są generowane losowo. Ma to gwarantować, że każda osoba spełniająca kryteria kwoty ma równe szanse na znalezienie się w próbie.

Bardzo ważna jest wielkość próby. Generalna zasada mówi, że im większa jest próba, tym dokładniejszy będzie wynik badania. Czyli jeśli przebadamy 500 osób, to błąd statystyczny może wynieść 4,3 proc., a jeżeli 1000, to już 3,1 proc. Błąd statystyczny informuje nas o tym, jak duża może być rozbieżność między wynikami uzyskanymi dla próby a rzeczywistymi wartościami dla całej populacji. Czyli jeśli polityk uzyskał w badaniu poparcie 30-proc. i błąd statystyczny badania wynosi 3 proc., to jego rzeczywisty wynik poparcia mieści się pomiędzy 27 a 33 proc.

Kolejnym ważnym elementem badania jest opracowanie kwestionariusza. Jest to narzędzie, za pomocą którego dane są zbierane od respondentów. Konstrukcja kwestionariusza wymaga staranności i precyzji, aby pytania były jasne, zrozumiałe, neutralne i niesugerujące odpowiedzi. Wbrew pozorom duże znaczenie mają elementy na pierwszy rzut oka nieistotne, nawet kolejność pytań. Najlepiej, gdy pytania ogólne padają na początku i dopiero po nich pojawiają się pytania szczegółowe. Często też pytania rotują, dodaje się też pytania sprawdzające. Wszystko po to, by uniknąć choćby nieświadomego podpowiadania ankietowanym preferowanej odpowiedzi.

Następnym krokiem jest przeprowadzenie ankiety z wylosowanymi osobami. Teraz badacze muszą podjąć decyzję co do sposobu jej przeprowadzenia. Czy będzie to rozmowa bezpośrednia (F2F), wywiad przeprowadzany przez telefon z wykorzystaniem komputera (CATI), czy też respondenci samodzielnie wypełnią ankietę online (CAWI). Istnieją też metody mieszane, np. część to rozmowy bezpośrednie, a część przez telefon. Każda z nich ma wady i zalety. Ankiety bezpośrednie najczęściej dają najwyższy wskaźnik odpowiedzi. Umożliwiają też zadawanie bardziej złożonych pytań, ale ich wadą jest wysoki koszt i ryzyko, że ankieter, nawet niechcący, może wpływać na odpowiedzi.

Ankiety telefoniczne, bardzo popularne, charakteryzuje stosunkowo niski koszt i lepsza kontrola pracy ankietera. Wady to przede wszystkim ograniczona liczba pytań, jakie można zadać, oraz trudność z dotarciem do grup osób, które z definicji nie odbierają połączeń z nieznanych numerów.

Ostatnie, czyli ankiety internetowe, mają najniższy koszt dotarcia i bardzo szybko gromadzą dane. Niestety ich wadą jest niska reprezentatywność próby (tylko osoby korzystające z internetu) i ryzyko nieszczerych odpowiedzi.

Badacze podkreślają, że ważnym elementem, często wpływającym na wiarygodność sondaży, jest prawidłowe oszacowanie frekwencji wyborczej. W tekście „Jak czytać sondaże”, który ukazał się na stronach serwisu Lokalnapolityka.pl, zwraca się uwagę, że prawidłowe oszacowanie frekwencji jest podstawowym i niekiedy najtrudniejszym zadaniem firmy badawczej. Wynika to z faktu, że preferencje wyborcze ogółu społeczeństwa różnią się od preferencji tej części populacji, która faktycznie idzie na wybory i głosuje.

Zjawisko to zostało zilustrowane przykładem badania przeprowadzonego przez TNS na zlecenie Prawa i Sprawiedliwości przed wyborami prezydenckimi w Radomiu w 2014 roku. Firma badawcza przeszacowała frekwencję prawie dwukrotnie, co doprowadziło do błędnego oszacowania różnicy między dwoma kandydatami o ponad 16 proc.

NIE CHCĄ ODPOWIADAĆ

Problem niskiego wskaźnika odpowiedzi respondentów na wyniki sondaży obrazowo zaprezentowali naukowcy z Uniwersytetu Warszawskiego na stronie „Na straży sondaży” (nastrazysondazy.uw.edu.pl). W badaniach CBOS i TNS Polska z listopada 2023 roku, przeprowadzonych w podobnym czasie, wystąpiły znaczące różnice. Według CBOS Platforma Obywatelska miała 11 proc. przewagi nad PiS, a według TNS Polska PiS miał 3 pkt. proc. przewagi nad Platformą. Naukowcy tłumaczą te drastyczne różnice „spadającym poziomem realizacji próby”, czyli niskim wskaźnikiem odpowiedzi. Dodatkowo, mimo iż próba jest na 1000 osób, to w rzeczywistości deklarację wyborczą składa często ledwo połowa. Pozostali twierdzą, że nie wezmą udziału w głosowaniu albo nie są jeszcze zdecydowani, na kogo oddadzą głos.

Tłumacząc różnice w sondażach, naukowcy z UW zwracają uwagę, że w niektórych przypadkach może dochodzić do tzw. efektu ośrodka (house effect), związanego z postrzeganiem ośrodków badawczych przez respondentów. Tłumaczą go tak: „Choć jesteśmy przekonani, że nie ma żadnych podstaw, by zarzucać CBOS intencjonalne zawyżanie poparcia dla partii rządzącej, to jednak powtarzane w mediach slogany: »CBOS jest finansowany przez rząd, więc manipuluje wynikami na korzyść Platformy Obywatelskiej«, mogą skłaniać część respondentów do odpowiadania zgodnie z domniemanymi oczekiwaniami ankietera (czyli zawyżać poparcie dla PO) lub prowadzić respondentów niepopierających PO do odmowy udziału w badaniu”.

Na kwestię oszacowania i odpowiedniej wagi jako potencjalnego źródła błędów zwraca również uwagę Rafał Sobczak, CEO firmy SoftArchitect, wspomagającej ośrodki badawcze w zbieraniu danych, organizator Forum Jakości Danych.

– Kluczem do kalibracji sondażu pozyskanego w sposób telefoniczny czy internetowy jest dobre oszacowanie, dobry model i wiedza, kim jest odmawiający. Jeżeli ktoś nie bierze udziału w sondażu, to przecież też na kogoś prawdopodobnie będzie głosował i sztuką jest, żeby dobrze oszacować wybory tych odmawiających. Zrobić to mogą tylko te sondażownie, które robią od wielu lat badania wyborcze, w tym exit poll pod lokalami. To tam buduje się niezbędną bazę wiedzy – tłumaczy Sobczak.

SONDAŻOWA NIEPEWNOŚĆ

– Problem z rozchodzeniem się sondaży z rzeczywistymi wynikami występuje na całym świecie i w wielu mediach, takich jak „The New York Times” czy „The Washington Post”, żywo dyskutuje się na tematy związane z kuchnią sondażową – zauważa Marcin Duma.

Jednym z głosów w tej dyskusji jest tekst Allison Parshall z „Scientific American” pt. „Why Election Polling Has Become Less Reliable”. Autorka wskazuje na wiele czynników, które sprawiają, że prognozy oparte na sondażach stają się coraz bardziej niepewne i podatne na spore błędy. Według niej w dużym stopniu winę ponosi spadający wskaźnik odpowiedzi, z którym mierzą się sondażownie. W przeszłości, gdy telefony stacjonarne były powszechne, wskaźniki odpowiedzi sięgały 60 proc., co umożliwiało uzyskanie reprezentatywnej próby populacji. Obecnie, w dobie telefonów komórkowych, identyfikacji numerów, SMS-ów i spamu, coraz mniej osób odbiera telefony z nieznanych numerów lub odpowiada na nieproszone wiadomości tekstowe. Jako przykład Parshall podaje szanowany sondaż prowadzony przez „The New York Times” i Sienna College, w którym wskaźnik odpowiedzi wynosi jedynie… 1 proc. Tak nikła liczba odpowiedzi zmusza badaczy do ważenia odpowiedzi niektórych respondentów. Problem jednak w tym, że założenia przyjmowane w tych modelach, np. waga, jaką nadaje się niektórym odpowiedziom, mogą być źle dobrane. Nie jest to wina badaczy, tylko metody, która opiera się na subiektywnej ocenie ważności i wielkości poszczególnych wag. Jako przykład Parshall przytacza sondaże z 2016 roku, które przeceniły poparcie dla Hillary Clinton, głównie dlatego, że nie doceniono wagi wykształcenia jako czynnika wpływającego na preferencje wyborcze. W tym wypadku chodziło o wykształcenie osób rasy białej, które miały je na poziomie college’u i często głosowały na Trumpa.

W odpowiedzi na te błędy wiele sondażowni próbuje stosować inną technikę ważenia odpowiedzi – na podstawie deklaracji o tym, na kogo respondenci głosowali w ostatnich wyborach. Jednak badacze też są sceptyczni co do jej skuteczności, argumentując, że elektorat w ciągu czterech lat mógł znacząco się zmienić.

– Metodologia badań politycznych i społecznych się zmienia, a problem zmniejszającego się wskaźnika odpowiedzi dotyczy wszystkich, w tym Polski. Jednak u nas ten wskaźnik nie jest aż tak niski – zauważa Marcin Duma. – Badacze stają obecnie przed dylematem, czy prowadzić badania zgodnie z opracowanymi przez Gallupa sto lat temu metodami naukowymi i zgodzić się na błędy, czy opracować i stosować narzędzia, które nie są w kanonie badań, ale powiedzieć prawdę. Najczęściej brakuje nam w odpowiedziach ludzi z mniejszych ośrodków, np. wsi, mniej wykształconych. To samo dotyczy osób o poglądach konserwatywnych, mniej zarabiających i oczywiście młodzieży, która generalnie nie chce brać udziału w sondażach – dodaje Duma.

SZYBKO, TANIO, ALE CZY RZETELNIE?

Do podobnych jak Parshall wniosków doszedł Luc Bronner z „Le Monde”. Jego materiał, właściwie śledczy, wywołał sporą dyskusję we Francji. Dziennikarz, posługując się fikcyjnymi tożsamościami, wziął udział w ponad 200 sondażach przeprowadzonych przez renomowane instytuty, takie jak Ipsos, IFOP, Kantar, BVA i OpinionWay. W swoim materiale za główne zło uważa tzw. panele dostępowe, czyli internetowe bazy respondentów, które według niego są wykorzystywane przez instytuty badawcze do przeprowadzania szybkich i tanich sondaży. Działają one w ten sposób, że ludzie się w nich rejestrują, podając podstawowe dane osobowe i informacje o swoich preferencjach, często w zamian za niewielkie wynagrodzenie. Autor widzi w tym kilka problemów, które wpływają na jakość sondaży. Po pierwsze, weryfikacja danych respondentów jest ograniczona, co otwiera drogę do nadużyć i fałszywych profili. Sam Bronner przyznaje, że stworzył ich kilkanaście i raz był mieszkańcem przedmieść Paryża, raz rentierem z Lazurowego Wybrzeża, raz chłopem z Normandii, a raz inżynierem z Tuluzy. Po drugie, panele zachęcają do częstego udziału w ankietach, co może prowadzić do powstania grupy „profesjonalnych respondentów”, których odpowiedzi nie odzwierciedlają rzeczywistych poglądów społeczeństwa. Po trzecie, nie ma kontroli nad tym, ilu respondentów uczestniczy w panelach różnych instytutów. To z kolei utrudnia ocenę reprezentatywności próby i zwiększa ryzyko, że te same osoby będą wielokrotnie odpowiadały na podobne pytania, a tym samym wpływały na wyniki sondaży.

Na poparcie swoich tez Bronner przytacza kilka przykładów. Dziennikarz, korzystając ze swoich fikcyjnych tożsamości, mógł bez trudu wielokrotnie brać udział w ankietach tego samego instytutu. Przedstawia również przypadek 1000 internautów z panelu Ipsos, którzy w ciągu miesiąca wypełnili ponad 11 700 ankiet, co rodzi pytania o wiarygodność ich odpowiedzi.

Bronner zwraca też uwagę na problem ważenia wyników sondaży, szczególnie tych o charakterze politycznym. Firmy badawcze nie chcą się dzielić metodami, jakie stosują przy ważeniu, uznając to za swoją tajemnicę handlową. Ten brak przejrzystości rodzi obawy o potencjalne manipulacje wynikami sondaży. Wystarczy przecież nadać wyższe wagi niektórym grupom, by podrasować wyniki.

AI POMOŻE CZY ZASZKODZI?

Duże ośrodki badawcze za granicą próbują rozwiązać ograniczenia tradycyjnych metod zastosowaniem dużych modeli językowych (LLM), potocznie zwanych sztuczną inteligencją. Zamiast odpytywać respondentów, można stworzyć syntetyczne próbki, które odpowiadają jak poszczególne grupy respondentów. Modele te uczą się wzorców z rzeczywistych danych zebranych w trakcie wcześniejszych badań, exit poll, wyników wyborów i generują syntetyczne dane, które odzwierciedlają wzorce występujące w badanej populacji. Potencjalne korzyści są na tyle kuszące, że duże międzynarodowe ośrodki próbują udoskonalać tę metodę. W przypadku modeli językowych jakość syntetycznych próbek zależy od jakości danych użytych do uczenia modelu. Należy też wypracować sposoby weryfikacji takich próbek, no i bardzo ważne są kwestie etyczne, szczególnie w kontekście badań wyborczych, które oczywiście w pewnym stopniu wpływają na wyniki wyborów, a na pewno na przebieg kampanii.

Krytycy wykorzystania sztucznej inteligencji w badaniach opinii publicznej twierdzą, że modele uczą się na danych, które mogą zawierać uprzedzenia, co w efekcie może przenieść się na odpowiedzi syntetycznych respondentów. Co gorsza, modele te są uzależnione od danych historycznych, a więc istnieje ryzyko, że nie będą uwzględniały zmian w zachowaniach wyborców lub konsumentów.

Rafał Sobczak z SoftArchitect stwierdza: – Śledzę rozwój modeli opartych na AI i nadal pozostaję sceptyczny, ponieważ jestem zwolennikiem metod, których wynik można sprawdzić innymi sposobami. Wyników paneli syntetycznych opartych na algorytmach sztucznej inteligencji nie można zdekomponować analitycznie, to znaczy sprawdzić dokładnie, które dane odpowiadają za wartość końcową. Nie wykluczam jednak, że w przyszłości panele syntetyczne staną się popularne – mówi.

Na razie nie grozi nam, by wyniki poparcia partii politycznych mierzone były za pomocą sztucznej inteligencji, bo takich badań jeszcze nikt nie robi. Nieoficjalnie jednak badacze twierdzą, że bardzo obiecujące wyniki zastosowania paneli syntetycznych są w badaniach reklamy czy marketingowych.

STATYSTYKA CZY WRÓŻBIARSTWO?

Żywa dyskusja w mediach, szczególnie za oceanem, na temat metod i technik sondaży wynika z tego, że nawet niewielkie różnice pomiędzy prognozami a rzeczywistymi wynikami są źle przyjmowane przez odbiorców. Padają oskarżenia o stronniczość względem jednej lub drugiej strony politycznego sporu. Tymczasem badania opinii publicznej to statystyka, w której istnieje pojęcie progu zaufania wynoszącego 95 proc. Można go zinterpretować jako wartość, która określa, jak bardzo możemy ufać wynikom naszego badania.

Wykonawcy sondaży i trafność wyników ich pracy także podlegają rankingom (np. Konkurs o Puchar Pytii, organizowany przez Centrum Badań Ilościowych nad Polityką UJ). Warto, aby media samodzielnie były weryfikatorem jakości badań. Niestety, tak nie jest. – Nikt nie podaje ważnych szczegółów badań, bo nikt o nie nie pyta – mówi Maciej Siejewicz z Surveyshow.

***

Ten tekst Stanisława M. Stanucha pochodzi z magazynu „Press” – wydanie nr 1-2/2025. Teraz udostępniliśmy go do przeczytania w całości dla najaktywniejszych Czytelników.

„Press” do nabycia w dobrych salonach prasowych lub online (wydanie drukowane lub e-wydanie) na e-sklep.press.pl.

Czytaj też: Nowy "Press": Haszczyński, konsekwentna Zetka, wspomnienia o Tymie i Pytlakowskim

Stanisław M. Stanuch