Jak sztuczna inteligencja może wspomóc redaktora. Porównanie popularnych modeli

Odpowiednio wykorzystana generatywna sztuczna inteligencja może pomóc redaktorom w pracy (fot. BoliviaInteligente/Unsplash.com)

Przebadałem kilka popularnych modeli generatywnej sztucznej inteligencji, jak sobie radzą w roli redaktora tekstu.

Praca redaktora sprowadza się do kilku etapów. Po pierwsze, redaktor sprawdza, czy tekst spełnia wymagania redakcji i zaspokaja potrzeby czytelników. Po drugie, usuwa błędy językowe, stylistyczne, składniowe i merytoryczne, dbając o jasność przekazu. Po trzecie, doskonali strukturę i kompozycję tekstu. Na koniec weryfikuje fakty i źródła. Czy popularne modele AI mogą wspomóc albo nawet już zastąpić redaktora?

Zastanawiając się, jak podejść do tego testu, początkowo uznałem, że idealnym rozwiązaniem byłoby, gdyby AI po wskazaniu tekstu dostarczyła mi go już w stanie zredagowanym. „To jednak nie jest optymalne rozwiązanie, ponieważ nie poznam wtedy wszystkich poprawek wprowadzonych przez model.”

AI może poprawić ewidentne błędy, ale równocześnie wprowadzić własne, nowe. Lepszym podejściem wydaje się zatem, by model zaproponował poprawki w tekście, a po uzyskaniu naszej akceptacji wprowadził je do artykułu. Chociaż, przyznam szczerze, ja sam wolę dmuchać na zimne i ręcznie wprowadzać zaproponowane poprawki. Do przetestowania możliwości różnych rozwiązań stworzyłem tekst na podstawie różnych informacji i wywiadów z Rafałem Brzoską. Następnie zleciłem generatywnej sztucznej inteligencji wprowadzenie do niego różnych błędów: ortograficznych, stylistycznych, interpunkcyjnych czy gramatycznych. Do testowania wybrałem kilka popularnych modeli w wersji bezpłatnej (Gemini, ChatGPT, Grok) i jeden w wersji płatnej (Perplexity Pro). Do tej listy dodałem też LanguageTools, bo to program wykorzystywany przez wielu redaktorów, a ja sam używam jego płatnej wersji od kilku lat.

GOOGLE GEMINI JAKO REDAKTOR

W marcu 2025 roku Google wprowadził w bezpłatnej wersji funkcję gemów. To rodzaj asystentów zaprogramowanych do realizacji określonych zadań. Dostęp do nich jest możliwy bezpośrednio ze strony modelu AI Google’a – Gemini (https://gemini.google.com) lub przez aplikacje na iOS i Android.

Jednym z gemów Google’a jest „Redaktor tekstów”. Na stronie Gemini, w panelu po lewej stronie dostępna jest opcja „Przeglądarka gemów”. Po wybraniu tej opcji i naciśnięciu „Pokaż więcej” pojawi się m.in. „Redaktor tekstów”. Po kliknięciu w panelu otwiera się okno czatu z czterema propozycjami promptów:

– sprawdzenie błędów gramatycznych,

– wprowadzenie zmian zgodnie z przewodnikiem po stylu,

– przepisanie zdania dla większej zrozumiałości,

– poprawa płynności zdań, doboru słów i spójności stylu.

Można skorzystać z jednego z promptów Google’a lub wpisać własny, np. „Zredaguj załączony tekst” w oknie czatu. Wybieram czwarty kafelek: „Poprawa płynności…” i uruchamiam go w okienku czatu. Pierwszym efektem działania „Redaktora tekstów” są trzy pytania: Jaki jest główny cel artykułu? Do kogo jest skierowany? Jaki rodzaj informacji zwrotnych jest oczekiwany? Po wpisaniu odpowiedzi klikam ikonę „+” w oknie czatu i wskazuję na dysku tekst artykułu do redakcji. Po chwili otrzymuję dość obszerny efekt pracy gema, podzielony na siedem części: ogólne komentarze, poprawki pisowni, poprawki gramatyczne, sugestie dotyczące płynności tekstu, sugestie dotyczące struktury, obszary do poprawy i wskazówki dotyczące formatowania.

(screen: Magazyn „Press”, nr 9-10/2025)

W ogólnych komentarzach Gemini sugeruje usunięcie potocznych wyrażeń, zastąpienie niektórych słów synonimami, zmianę budowy zdań oraz korektę ortografii, interpunkcji i błędów gramatycznych. Kolejna część raportu SI to lista błędów z dokładnym wskazaniem linii, proponowaną poprawką i uzasadnieniem. Na przykład w linii 28 słowo „niebyła” proponuje zamienić na „nie była”, uzasadniając to tym, że partykułę „nie” z czasownikiem piszemy oddzielnie. W przypadku błędów gramatycznych zastosowano podobny schemat, ale tu najczęściej podawane jest całe zdanie i jego poprawiona wersja, z obszerniejszym wyjaśnieniem wszystkich zmian. W sekcji obszarów do poprawy Gemini zwraca uwagę na zróżnicowanie wprowadzania cytatów. Zamiast powtarzać „wspomina” czy „mówi”, sugeruje inne czasowniki, np. „podkreśla”, „zaznacza”, „wyjaśnia” lub „dodaje”. Na koniec gem pyta, czy chcę, aby wygenerował poprawiony tekst z uwzględnieniem zaproponowanych poprawek. Dostępne są dwa rozwiązania: ręczne wprowadzenie poprawek z możliwością ich pominięcia lub modyfikacji albo zlecenie przepisania tekstu z poprawkami. Brakuje jednak propozycji dotyczących struktury tekstu, np. zmian w tytule, leadzie czy śródtytułach. W przypadku śródtytułów „Redaktor tekstów” pominął błąd charakterystyczny dla tekstów generowanych przez SI, czyli pisanie wszystkich słów wielką literą, co wynika z różnic w zasadach pisowni między językiem polskim i angielskim.

TWORZENIE WŁASNEGO GEMA

„Redaktor tekstów” w podstawowej formie nie spełnia wszystkich moich wymagań, lecz gemy w Gemini umożliwiają stworzenie własnego narzędzia i dostosowanie go do specyficznych potrzeb. Jeśli jeszcze raz przejrzymy gemy zaproponowane przez Gemini, zapewne dojrzymy spory niebieski przycisk „Nowy Gem”, który do tego właśnie służy. Po kliknięciu przycisku i nadaniu nazwy gemowi można określić jego funkcje, podobnie jak w promptach SI. Przydaje się tu umiejętność tworzenia promptów, o którym pisałem w poprzednim „Press” (07-08/2025).

Dla osób chcących eksperymentować z własną wersją sugeruję skopiowanie oryginalnego gema Gemini i na jego podstawie dodanie brakujących poleceń. By to zrobić, kliknij w ikonę w prawym górnym rogu obrazka gema. Dzięki temu możesz przejrzeć treść prompta oraz w razie potrzeby dodać własne polecenia i materiały, które Gemini uwzględni. Takim materiałem, który możesz dodać, może być plik z redakcyjnym stylebookiem. Podczas tworzenia lub edycji kopii gema dużym ułatwieniem jest specjalny przycisk w okienku do optymalizacji zapisanego prompta. Po kliknięciu przycisku Gemini optymalizuje instrukcje, często dodając elementy, które mogły zostać pominięte. Stworzoną kopię lub dodatkowo zoptymalizowany gem wystarczy zapisać i później wykorzystywać jak każdy inny.

PORÓWNANIE MODELI

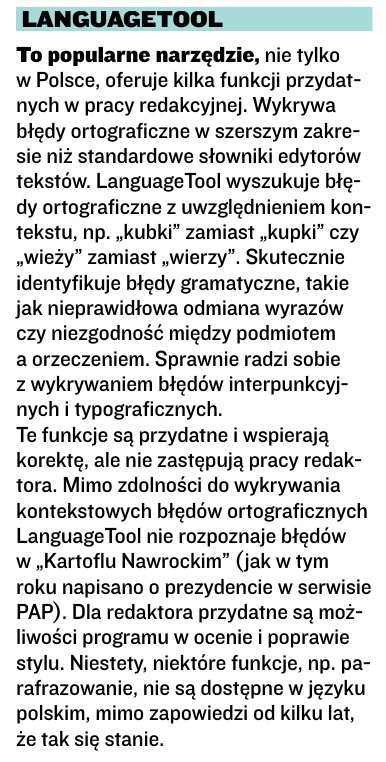

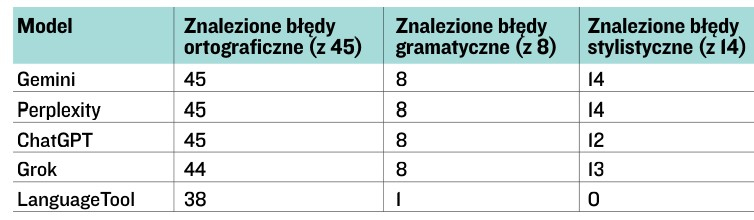

Zmodyfikowana treść prompta „Redaktora tekstów” posłuży mi do minitestu lub porównania jakości redakcji tekstu przez różne modele sztucznej inteligencji. Każdy poprawiony przez konkretny model artykuł zapisałem w osobnym pliku, a następnie sprawdzałem, ile błędów wykrył, a ile pominął. Wyniki umieściłem w tabeli.

Łącznie w tekście było 45 błędów ortograficznych, przede wszystkim literówek, ale także np. pisowni z „nie”, osiem błędów gramatycznych i 14 stylistycznych. W sumie 67 błędów. Pierwsze rzuca się w oczy to, że żaden model nie poprawił wspomnianego wcześniej błędu pisania słów w tytule od wielkich liter. Co ciekawe, LanguageTool też nie wskazał tego błędu, a przecież Słownik języka polskiego PWN jest w tym zakresie jednoznaczny. Po drugie: są różnice pomiędzy modelami, ale są one nieznaczne. Na przykład 100-proc. skuteczność, czyli wykrycie wszystkich błędów, osiągnęły Gemini i Perplexity, podczas gdy pozostałe modele wykazały skuteczność na poziomie 97 proc. Najniższą skuteczność osiągnął LanguageTool, wykrywając 39 z 67 błędów, czyli 58 proc. W jego przypadku należy zauważyć, że brak korekty stylistycznej odpowiada za niewykrycie 14 błędów.

ChatGPT doskonale poradził sobie z błędami ortograficznymi i gramatycznymi, ale przepuścił dwa niewielkie błędy stylistyczne. Grok poległ na jednym błędzie ortograficznym (pisownia z „nie”) i jednym stylistycznym.

Wyniki porównania w tabeli obok.

Diabeł jednak tkwi w szczegółach i różne modele różnie radziły sobie z zadaniami redakcyjnymi. Dlatego przygotowałem specjalne gemy dla każdego aspektu pracy nad redakcją tekstu i sprawdziłem, jak sobie z tym poradziły sprawdzane modele SI.

ANALIZA STRUKTURY TEKSTU

Jedną z czynności, jakie często wykonuje redaktor, jest dopracowanie albo całkowita zmiana struktury tekstu. Taka reorganizacja może obejmować zmianę położenia akapitów, dodawanie nagłówków, skracanie zdań – wszystko, co zwiększa ogólną spójność i czytelność tekstu. Okazuje się, że generatywna inteligencja może tu pomóc, chociaż nie spodziewajmy się cudów, bo tego typu redakcje mają m.in. na celu dostosowanie artykułu do stylu wybranej publikacji. Opracowany przeze mnie prompt, o ile uzna to za potrzebne, zaproponuje przesunięcie akapitów albo ich połączenie czy podzielenie. Wskaże też miejsca, gdzie powinny być nagłówki. Ocenę, jak poszczególne modele sobie z tym poradziły, oparłem na analizie ilościowej, czyli liczbie propozycji zmian, oraz jakościowej – oceniającej jakość zmian. Niekiedy to podejście może wprowadzać w błąd, bo np. ChatGPT zaproponował sporo zmian w akapitach i propozycji nagłówków, ale w gruncie rzeczy albo były mało ciekawe, albo po prostu zbyt proste i oczywiste. Zdecydowanie lepiej poradził sobie z zadaniem Gemini i Grok. W analizie Gemini przeczytałem: „Podzieliłbym wstęp na dwa krótsze akapity. Pierwszy akapit mógłby skupiać się na »dramatycznym« początku i obecnej pozycji InPostu, a drugi na osobie Rafała Brzoski i głównych wątkach, które zostaną poruszone w artykule”. I uzasadnienie: „Krótsze akapity na początku są bardziej przystępne dla czytelnika i zachęcają do dalszego czytania”. Obydwa modele przeprowadziły solidną analizę, a ich propozycje były trafne i dobrze uzasadnione. ChatGPT i Perplexity wypadły na tym tle dość skromnie. Analiza, właściwie w punktach, sprowadzała się do zaprezentowania struktury tekstu i porad w stylu: tu opisz to albo to.

FACT-CHECKING

Niezbędnym działaniem redaktora jest sprawdzenie wszystkich faktów, nazwisk i danych, do czego poprawnie użyta sztuczna inteligencja nadaje się doskonale. Wybrałem ręcznie 14 faktów z testowego artykułu. Były to głównie stwierdzenia Rafała Brzoski, które padły w różnych z nim rozmowach. Zadaniem prompta było sprawdzenie informacji w zewnętrznych źródłach, czyli by nie opierał się tylko na redagowanym tekście, oraz ocena, czy jest to prawda, fałsz, czy nie da się zweryfikować. Bardziej chciałem przetestować możliwości wyszukiwania źródeł i ich interpretacji przez modele niż to, czy te informacje są prawdziwe, czy nie, bo to akurat wiedziałem. W tym eksperymencie widać, że prompty często działają różnie w różnych modelach i dlatego zawsze trzeba poświęcić trochę czasu na eksperymenty, wyciąganie wniosków i dopracowywanie promptów. W przypadku fact-checkingu Gemini kompletnie się pogubił. Potwierdził wszystkie informacje, uznając za wystarczające źródło… artykuł testowy. W identyfikacji faktów do sprawdzenia najlepiej wypadł ChatGPT, który wykrył wszystkie 14, a najsłabiej Perplexity, któremu udało się zidentyfikować 10 uznanych przeze mnie za warte sprawdzenia informacji. Modele znacznie różniły się w prezentacji źródeł. ChatGPT i Perplexity zrobiły to najgorzej, prezentując jedynie nazwy, np. „artykuł w Forbes”. Wzorowo zrobił to Grok, który za każdym razem podawał link do cytowanego źródła.

POMYSŁY NA ROZWINIĘCIE TEKSTU

Postanowiłem też sprawdzić, jak modele poradzą sobie z pomysłami na rozwinięcie artykułu. Nie jest to redakcja tekstu, ale z pewnością nieraz takie sugestie przekazują autorowi redaktorzy. Nie było trudne do udowodnienia, że w kreatywności sztuczna inteligencja sprawdza się całkiem nieźle. Nawet jeśli nie wszystkie propozycje są idealne, to stanowią dobry fundament do opracowania lepszych. Zgodnie z moimi przewidywaniami każdy model polecił mi kilka tematów, które mogłyby wzbogacić artykuł. Ich ocena może być oczywiście subiektywna. Mnie osobiście najbardziej przypadły do gustu propozycje ChatGPT, który nie tylko podał ciekawe tematy, jak np. wpływ Brzoski na rynek pracy i przedsiębiorczości w Polsce, ale również przekonująco je uzasadnił. Ciekawie podszedł do tematu Gemini, którego propozycje oparte były na głębokiej analizie wybranych fragmentów tekstu i propozycji ich wzbogacenia dodatkowymi elementami. Na przykład gdy Rafał Brzoska wspominał, że w roku 2015 jego firmy przeżyły kryzys, który o mało co nie doprowadził do ich upadku, Gemini zaproponował, by rozwinąć temat i dodać, jakie lekcje można wyciągnąć z postępowania bohatera, czego powinno się unikać i jak się zachowywać w podobnych sytuacjach.

(screen: Magazyn „Press”, nr 9-10/2025)

W propozycji Groka ciekawy był wątek, w którym proponował dodanie przykładu współpracy z konkretnym inwestorem albo objaśnienie – dzisiaj to oczywistość – czyli, jak paczkomaty zrewolucjonizowały logistykę przesyłek oraz z jakimi wyzwaniami się to wiązało. Propozycje Perplexity częściowo pokrywały się z innymi, ale ciekawe w nich było, że przy każdej jako jedyny zaproponował, że może dla mnie zrobić research.

Reasumując, wykorzystanie generatywnej inteligencji w tym przypadku pewnie bardziej przyda się autorowi niż redaktorowi. Warto też sprawdzić każdy model z osobna, bo jak pokazuje praktyka, każdy z nich nie tylko zwrócił uwagę na różne tematy, ale też dobrze uzasadniał swój wybór.

WERYFIKACJA SPÓJNOŚCI I ARGUMENTACJI

Dobry tekst cechuje spójność. Nie bez powodu w amerykańskich mediach często na materiały dziennikarskie mówi się „story” (opowieść, historia), a nie artykuł. Ważna jest też argumentacja i jej jakość. Do oceny tych elementów modele sztucznej inteligencji nadają się doskonale. Co prawda, znowu, nie zastąpią dobrego redaktora, ale np. autorowi, który podda takiej ocenie swój tekst, mogą dostarczyć wiele cennych uwag.

ChatGPT w tekście o Rafale Brzosce zwrócił uwagę na miejscami potoczny język, który wpływa negatywnie na spójność narracyjną. Chodziło głównie o obecne w tekście wtrącenia w stylu „no wiesz” czy „jakby nie patrzeć”. Przekonywał też, że argumentacja miejscami jest słaba, szczególnie w ocenie sukcesu firmy bohatera. Uważał, że w artykule powinno być więcej faktów i liczb. Wskazał też miejsca, gdzie narracja bez płynnego przejścia przechodzi z jednego tematu na inny.

Co ciekawe, Gemini właściwie podkreślił te same braki co ChatGPT. Zupełnie inaczej do tego podeszły dwa pozostałe, które analizowały akapit po akapicie i skupiły się bardziej na precyzji przekazu, zarzucając niekiedy jej brak. Bardzo podobała mi się forma, w jakiej swoje uwagi przedstawił Perplexity: tabela z problemem, jego opisem i propozycją, jak można to poprawić: „To nie jest historia o szczęściu, ale o determinacji, pokorze i żelaznej konsekwencji, które zrodziły się z poczucia, że zawsze trzeba nadrabiać zaległości”. Perplexity sugerował „brak konkretnego przykładu ilustrującego determinację i konsekwencję”. I proponował: „Dodać przykład z życia bohatera, np. decyzję o inwestycji ostatnich pieniędzy w ogłoszenie”.

TWORZENIE COPY DO SOCIAL MEDIÓW

Ostatnią rzeczą, którą sprawdziłem, było stworzenie zajawek artykułu do mediów społecznościowych: Facebooka, X, LinkedIn i Instagrama. Co prawda nie jest to praca redaktora, ale z pewnością promocja tekstów w social mediach ma wpływ na popularność artykułów. Najlepiej sprawdziły się Gemini i Perplexity. Obydwa napisały chwytliwe, dobrze dostosowane do konkretnych platform treści. Udało im się zidentyfikować najbardziej zaciekawiające elementy tekstu, jak np. „gmina Nędza” (w której urodził się Brzoska) czy ostatnie 500 zł wydane na ogłoszenie, które uratowało go od bankructwa. Wyraźnie odstawał od reszty Grok, którego propozycje były nijakie i przede wszystkim mało kreatywne. Gdzieś pośrodku widzę ChatGPT. Jego propozycje są poprawne, dobre, ale oparte na ogólnym przekazie.

DLA REDAKTORÓW I... DZIENNIKARZY

Z mojego testu jasno wynika, że redaktorzy mogą spać spokojnie i na razie nie grozi im bezrobocie. Jest przeciwnie – odpowiednio wykorzystana generatywna sztuczna inteligencja może im pomóc w ich pracy, automatyzując niektóre czynności.

Potwierdza to ostatni test, jaki zrobiłem, wykorzystując „Job automation calculator”, jedną z funkcji serwisu Jobforagent.com. Wystarczy podać w nim link do ogłoszenia albo wkleić treść ogłoszenia (lepiej działa), by po chwili dostać informację, na ile dane stanowisko można zautomatyzować. Stworzyłem fikcyjne wymagania dla stanowiska redaktora, zawierające m.in. takie obowiązki, jak: merytoryczna, stylistyczna i językowa redakcja, weryfikacja faktów, praca nad stylem, współpraca z autorem, SEO – jednym słowem praktycznie wszystkie czynności, które w swojej pracy wykonuje redaktor. Odpowiedź: 51 proc. można zautomatyzować. Niewiele.

W raporcie serwis skupił się na 14 różnych aspektach pracy na tym stanowisku, oceniając w skali od 1 do 5, na ile można je zautomatyzować, i dodając niewielki komentarz do każdej oceny. Najwyższe oceny, co oznacza, że tę pracę można w praktyce zupełnie zautomatyzować, przydzielono dwóm zadaniom, jak używanie automatyki w programach biurowych i różnego rodzaju aplikacjach, np. do planowania jak Trello. Nieco niższą, czyli 4, nadano takim zadaniom, jak sugestie dotyczące stylu, zgodności z linią redakcji, ale z zastrzeżeniem, że wymagają często subiektywnego spojrzenia, a więc sprawdzenia wyników sztucznej inteligencji. Całkiem nieźle wypada automatyzacja fact-checkingu. Tu oczywiście również niezbędny jest nadzór redaktora, ale automatyczny fact-checking pozwala wyeliminować podstawowe błędy, jak np. źle napisane nazwy, nazwiska czy daty, co znacząco skróci czas redakcji. Najmniej podatne na automatyzację są wszelkie rzeczy związane z językiem i opowiadaniem historii. To dość oczywiste, bo wymaga ludzkiego oka i doświadczenia, którego nawet napakowana wiedzą sztuczna inteligencja długo nie zastąpi.

I na koniec: zestaw promptów do sprawdzania tekstu pod kątem ortografii, gramatyki, interpunkcji czy fact-checkingu jest bardzo przydatny… autorom. Zapewniam, że odpowiednio wykorzystany sprawi, że redaktorzy będą mieli mniej pracy z naszymi tekstami. A przez to będą je chętniej u nas zamawiać.

***

Ten tekst Stanisława M. Stanucha pochodzi z magazynu „Press” – wydanie nr 9-10/2025. Teraz udostępniliśmy go do przeczytania w całości dla najaktywniejszych Czytelników.

„Press” do nabycia w dobrych salonach prasowych lub online (wydanie drukowane lub e-wydanie) na e-sklep.press.pl.

Czytaj też: Nowy "Press": Antoni Słodkowski, bracia Karnowscy, Szymon Hołownia i AI

Stanisław M. Stanuch